<2001年度森基金研究成果報告>

カオスニューラルネットによる汎用的画像処理システム

慶應義塾大学 政策・メディア研究科 博士課程2年 福原 義久

概要

パターン認識は画像認識や音声認識技術の基礎となる技術である。パターン認識のための手法は特に生物の脳の構造を模倣した人工ニューラルネットワークの分野で発展をとげてきた。前年度までの成果として、重複したパターンを高速に一度に分離することができるパターン認識システムを開発済みである。この研究成果を、より実際的な問題、特に実画像識別に適用させた。本研究により、動画像からの画像認識やひいては複数音声の同時認識といった既存のモデルでは高い計算コストを要する問題を高速且つ高精度に処理できるようになる。

1. 背景

パターン認識技術は音声や画像データが大量に流通する現代においては必須の技術である。我々が取り扱わなければならないパターンは郵便番号のような簡単な記号から、指紋や音声、暗号といった非常に複雑なものへと急速に発展している。特に画像認識や音声認識といった、複雑かつ不安定な入力値を扱う場合には高度なアルゴリズムと高い計算コストが要求される。自然界からの情報には例えば欠落や重複といった様様な種類のエラーやノイズが含まれている。これらに対処するために、ある入力値に対しエラーやノイズを除去し、それがどのパターンであるかを特定する技術としてパーセプトロン[1]や連想記憶メモリ[2]など様様なものが開発されている。

本研究の前段階として、重複したパターンを的確に識別・分離する手法をカオスニューロンモデルと確率発火モデルの2つの手法でそれぞれ動作することを確認した[5,6]。

今年度の研究としては、特に確率発火モデルにおける実装と、実画像識別への応用を行った。提案モデルは、ニューラルネットワークにおけるパターン認識では古典的なモデルであるバックプロパゲーション学習を3層のニューラルネットワークに適用するだけで、重複画像の分離という複雑な情報処理を実現している。

2. 手法

提案モデルはニューラルネットワークでパターン処理を行うための古典的手法であるバックプロパゲーション技法を用いて学習を行う。パターンの学習過程においては、ニューロン素子として古典的なシグモイド関数を用い学習を行い、学習後のネットワークのニューロン素子を確率発火モデルに置き換える。

2.1. バックプロパゲーション

バックプロパゲーションはRumelhartによって提案されたニューラルネットに対する教師付き学習法である[3,4]。出力と教師信号との誤差を学習により小さくしていくことによりパターン識別を可能とする。出力と教師信号との誤差は式(1)によって示される。Tは教師信号でOは出力である。またj番目のニューロンとi番目のニューロンとの結合は式(2)によって更新される。

(1)

(1)

(2)

(2)

2.2. 確率発火モデル

確率発火モデルとは、ニューロン素子の出力がニューロンの発火の確率として扱われるモデルである。ボルツマンマシン[7]などの古典的なアプリケーションにも用いられている手法である。

確率発火モデルを識別時のニューロンに適用する。ニューロンの内部状態はシグモイド関数であらわされ、発火の可能性Pは式(3)としてあらわせる。

![]() (3)

(3)

2.3. 学習と認識

提案モデルは図1に示したような2層のニューラルネットから成っている。

パターンの学習はバックプロパゲーション学習を用いて行う。この際ニューロン素子は式(4)に示したシグモイド関数を用いる。

![]() (4)

(4)

パターンの想起を行う際に、素子の発火を確率的に扱うことにより、重複パターンの分離が可能となる。確率性による不安定要因により同じ入力値でも異なる出力を示す可能性がある。同じ入力値でも数回から数十回の試行を行い、出力を統計的に扱う必要がある。

図1:ニューロン素子の交換

3. シミュレーション

提案モデルの画像識別への適用をおこなった。入力層1600ニューロン、中間層30ニューロン、出力層4のニューロンから成るネットワークに図2に示した4つの8bitグレイスケール画像を学習させた。学習は学習誤差E<0.002に達するまで行い、連続した100回の出力を集計した。

図2:記憶パターン

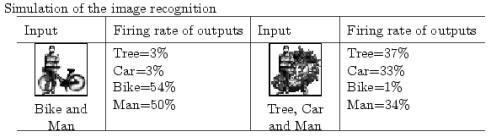

2つ及び3つのイメージが重なった画像を提案システムに入力値として与えた場合の結果を図3に示す。表中の値は、それぞれのイメージを指し示す出力層ニューロンの発火率を示している。提案手法は重なったイメージを的確に分離識別していることが確認された。

図3:実験結果

次に、本実験における計算コストについて述べる。表1に示した実験環境でシミュレーションを行った。

表1:計算機環境

|

CPU |

Pentium Celeron 500Mhz |

|

Memory |

256 MB |

|

Operating System |

Windows 2000 professional |

|

Development Language |

Borland Delphi 5.0 |

表2は本実験における学習と認識の計算速度の結果である。この実験では、学習は学習誤差E

< 0.002の時点まで行い、連続した30回の出力を得るための時間を計測した。提案システムは1600入力のネットワークで360msという高速な処理が可能である。

表2:計算コスト

|

Network Configuration |

Learning Speed |

Segmentation Speed (30 times) |

|

Input : 400 neurons Hidden: 20 neurons Output : 4 neurons |

7832msec |

360msec |

4.結論

提案モデルは、ニューロンの確率発火を利用することにより、重複パターンの分離を的確に行うことができた。また従来提案していたカオスニューロンを用いた同様のモデルよりも耐ノイズ性や計算コストの面において優位性がある[7]。また、今回はじめてアナログ値による実画像に提案手法を適用して、その効果を確認した。これにより画像認識の分野において実用的に利用可能であることが証明された(この成果については現在Neuro-computing journalに投稿・査読中である)。

特に本システムは複雑な構造を持つ既存手法に比べて提案手法は古典的な学習手法であるバックプロパゲーションと単純な3層のネットワークから成る単純な構造のため、他システムへの組み込みや改変が容易であり様々な応用が考えられる。

参考文献

[1] Minsky,M

and Papert,S, “Perceptrons”, MIT

Press, 1969

[2] J.J.Hopfield,

“Neural Networks and Physical Systems with Emergent Collective Computational

Abilities”, Proc. Of National Academy of Science, U.S.A., 79,

pp.2445-2558, 1982

[3] Rumelhart,D.E.,Hinton,G.E.and

Williams,R.J. Learning representaions by back-propagating errors. Nature,Vol.323-9,

pp.533-536. 1986

[4] Rumellhart,D.E.,

Hinton,G.E. and Williams,R.J., “Learning internal representations by error

propagation, In D.E.Rumelhart, J.L.McCelland and PDP Research Group”,

Parallel distributed processing: Explorations in the microstructure of

cognition, Vol.1, pp.318-362, The MIT Press, 1986

[5] Y.Fukuhara,

Y.Takefuji, “Pattern segmentation of mixed figures by using statistical

neuro-dynamics”, IPMM-2001, Canada, 2001

[6] Y. Fukuhara, Y.Takefuji, “ Mixed pattern segmentation by using chaotic neural networks”, IPSJ, Vol. 4, No. SIG5(TOM4), May, pp 9-16, 2001

[7] Hinton, G.E., Sejnowski, T.J., and Ackley, D.H., “Boltzman Machines: Constraint Satisfaction Networks That Learn”, Tech. Rep., Pittsburg, PA, 1984