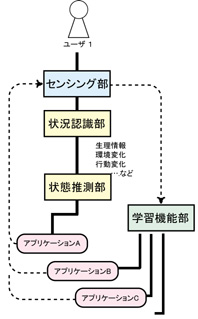

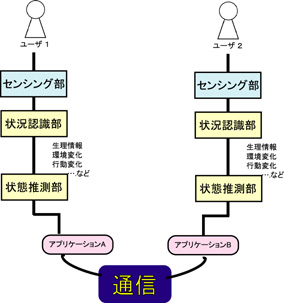

ユーザの状態を推測するために、ユーザの行動変化や環境の変化を監視する従来の状況認識技術に加え、ユーザの心身状態を推測可能な生理情報の変化をセンシングする。システム処理の流れを、以下に示す[図1]。

図1:コンセプトA

- ●センシング部:

- 日常生活の中で計測可能な情報を測定する

- ●状況認識部:

- 生理情報、環境変化、行動変化等を認識する

- ●状態推測部:

- 認識結果から、ユーザの心身的状態を推測する

- ●アプリケーション:

- 推測結果に応じて、ユーザに適切なサービスを提供する

- ●学習機能部

- ユーザを継続的にモニタリングするという利点を生かし、個人の特徴を蓄積していく学習機能を追加する。アプリケーションAを制御した結果、ユーザの状態が変化しない場合にはアプリケーションB、C…を動かす、というように、状態aに対するアプリケーションの候補やアプリケーション制御のタイミングを複数用意しておくことで、そのユーザの状態に最も適したインタラクション方法を学習していく。

例えば遠隔教育システムへ適用が考えられる。継続的なモニタリングから生徒の状態(疲労度が高まっている、興味を示しているなど)を推測し、自発的、あるいは教師側からのリクエストによって結果を提示する。講師側はそれに応じて講義のペースや内容を変化させることができ、豊かなコミュニケーションを支援できる。

図2:コンセプトB